Moderne Webseiten bestehen aus HTML, CSS – und JavaScript. Galt jahrelang der SEO-Ratschlag, dass Webseiten auch komplett ohne JavaScript funktionieren müssen, ist die JavaScript-Unterstützung des Googlebot mittlerweile so gut und umfangreich, dass dies nur noch eingeschränkt gilt. Experimente wie das von Bartosz Góralewicz zeigen, dass mittlerweile viele Funktionen der gängigen JavaScript-Frameworks von Google unterstützt werden.

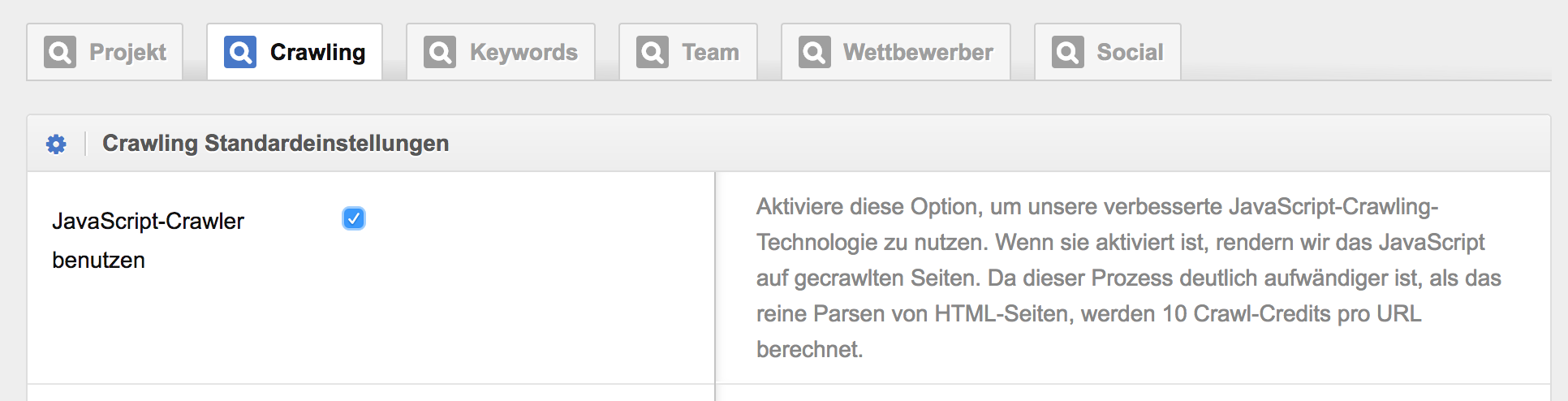

Ein guter Zeitpunkt also, dass auch der Optimizer das Crawling von Seiten unterstützt, die auf JavaScript basieren. Ab heute kann diese (noch experimentelle) Funktion in den Crawling-Einstellungen Deines Optimizer-Projektes aktiviert werden:

JavaScript-Crawling in den Projekt-Einstellungen aktivieren

Das Verarbeiten von JavaScript ist deutlich rechenintensiver als die Verarbeitung von reinen HTML-Seiten. Daher nutzt das neue JavaScript-Crawling im Optimizer je erfasster Seite 10 Crawlcredits – und nicht nur einen, wie das reine HTML-Parsing. Da Du aber bereits in der Basisversion des Optimizers 500.000 Crawlcredits zur Verfügung hast, steht auch der Auswertung umfangreicher JavaScript-Webseiten nichts im Wege.