Ein Werkzeug im Arsenal des Suchmaschinenoptimierers, welches bei der Steuerung von Crawlern auf dem eigenen Projekt genutzt werden kann, ist die robots.txt Datei. Diese Datei ist eines der ältesten Instrumente die einem ermöglichen, wohlgesonnenen Crawlern bestimmte Teile der eigenen Domain vorzuenthalten.

In der Praxis kommt häufiger der Fall auf, dass zu Testzwecken eine Änderung an der robots.txt vorgenommen werden sollte, diese Änderung aus verschiedenen Gründen jedoch nicht durchgeführt werden kann.

Um diese Testzwecke abzudecken und eine viel feinere Abstimmung des Crawlverhaltens für das eigene Projekt zu ermöglichen, ist es jetzt im Optimizer möglich, eine virtuelle robots.txt Datei zu aktivieren und zu befüllen.

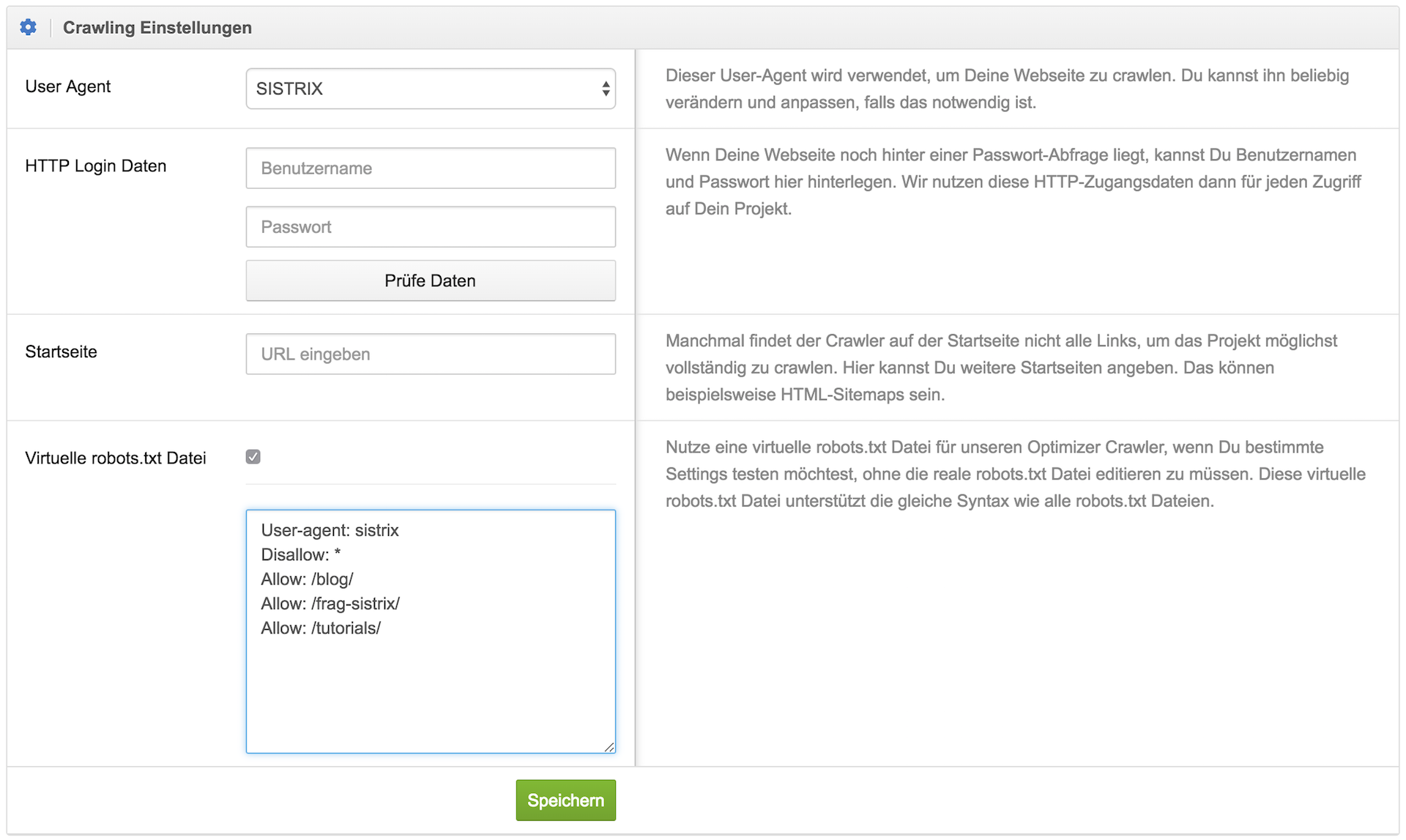

In jedem Projekt kannst Du jetzt unter „Projekt-Einstellungen > Crawler“, in der Box zu den crawling Einstellungen, auswählen, ob eine virtuelle robots.txt Datei, anstelle der realen Datei, genutzt werden soll.

Setze einfach das Häkchen und gib dann den Inhalt der Datei ein, wobei Du die gleichen Befehle wie in einer regulären robots.txt Datei nutzen kannst.

Unser Crawler wird beim nächsten Crawl des Projekts, den Du auch direkt nach der Umstellung manuell anstoßen kannst, die virtuelle robots.txt Datei anstelle der realen berücksichtigen.

Ein Anwendungsgebiet wäre zum Beispiel das eingrenzen des Crawls auf einige, bestimmte Verzeichnisse.