In den meisten Fällen sind die Rankings wahrscheinlich nicht verloren. Bei der Beantwortung dieser Frage kommt es jedoch sehr stark darauf an, wann die Website ausgeschlossen wurde.

Wenn eine Seite nicht indexiert werden kann, kann Google diese Seite auch nicht als Ergebnis ausliefern. Die erste Konsequenz sind verlorene Rankings.

Sollte die Deindexierung zeitlich noch nicht weit zurückliegen, dann ist es sehr wahrscheinlich, dass Google – nachdem du die Seiten wieder indexieren lässt –, die alten Rankings deiner URLs erneut einspielt.

Du solltest also in diesem Fall immer folgende drei Fragen hintereinander durcharbeiten:

- Seit wann ist das Ranking eingebrochen / die Seite nicht mehr im Index?

- Warum sind die Seiten nicht mehr im Index

- Was mache ich nach der Beseitigung der Fehler?

Seit wann ist das Ranking eingebrochen?

Sollte erst gestern aufgefallen sein, dass eine Seite nicht mehr in Googles Index vertreten ist, besteht der erste Schritt darin zu prüfen, seit wann die Seite nicht mehr im Index ist.

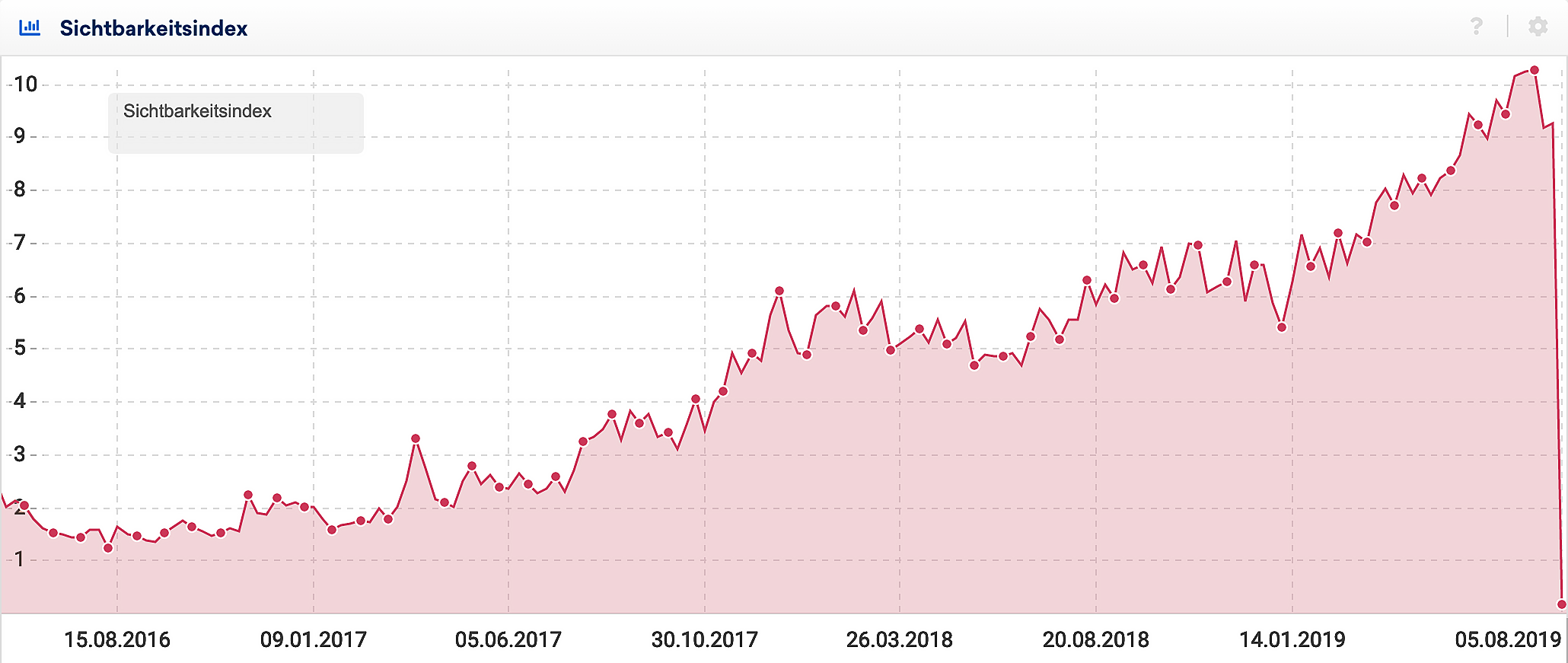

Um herauszufinden wann die Seite aus dem Index gefallen ist, könnt ihr den „Indexierungsstatus“ Bericht der Google Search Console konsultieren oder den Sichtbarkeitsindex Verlauf der Domain in der SISTRIX Toolbox überprüfen.

Da der Sichtbarkeitsindex abbildet, wie sichtbar eine Domain in den Google Suchergebnissen ist, wird dieser, bei einem Ausbleiben von Ergebnissen, entsprechende Verluste anzeigen.

In diesem Beispiel lässt sich ein massiver Absturz der Sichtbarkeit erkennen.

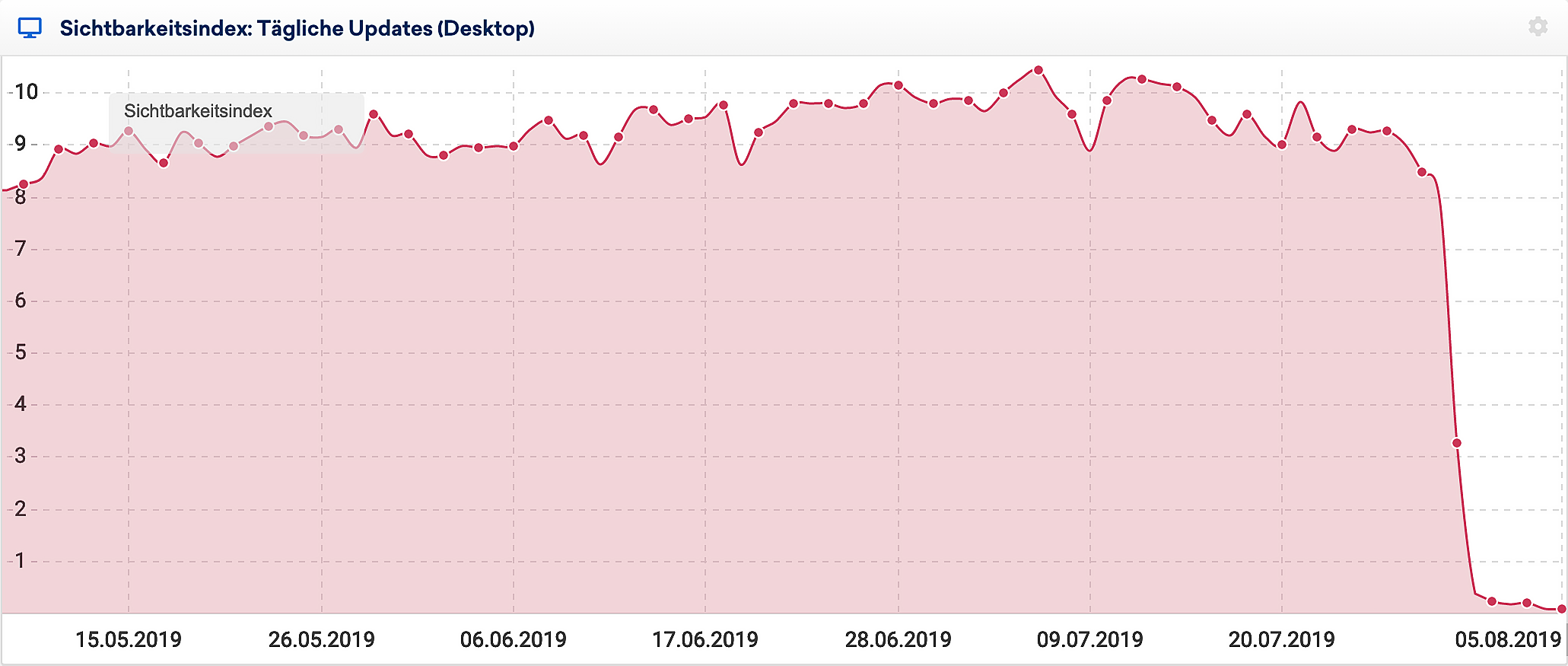

Liegt der Absturz weniger als 30 Tage zurück, kannst du sogar noch genauere Aussagen zum betreffenden Datum in unserem täglichen Sichtbarkeitsindex-Verlauf erkennen:

Wir können hier genau sagen, dass die Sichtbarkeit zwischen dem 29.07.2019 und 31.07.2019 eingebrochen ist und, bewaffnet mit diesem Wissen, mit der Detektivarbeit beginnen.

Warum sind die Seiten nicht mehr im Index?

Die robots.txt

Erster Anlaufpunkt sollte immer die robots.txt-Datei der eigenen Seite sein. Hier kann der GoogleBot von der Seite ausgeschlossen werden und wenn Google eine Seite nicht crawlen kann, dann wird diese Seite auch nicht dem Index hinzugefügt – wobei es natürlich auch hier bestimmte Ausnahmen gibt.

Die NoIndex-Anweisung

Danach lohnt sich ein Besuch der eigenen Webseite, um zu prüfen, ob die Seite aus Versehen auf Noindex gesetzt wurde. Das kann manchmal schon durch eine einzelne Checkbox im Content-Management-System passieren. In seltenen Fällen findet sich die Noindex-Anweisung nicht im Quellcode der Seite, sondern in der Server Response über das X-Robots-Tag.

Technische Probleme

Sind diese beiden Fehlerquellen geprüft, bleibt noch die Technik. Liegen z. B. Serverfehler vor oder führen automatische Abfragen nach kurzer Zeit zu einem Ausschluss der abfragenden IP? Um solche Fragen beantworten zu können, lohnt es sich direkt bei der Technik anzufragen oder die Seite mit dem SISTRIX Onpage Projekt-Tool crawlen zu lassen. Dieser crawlt automatisch deine Website und du kannst schon während des Crawls im „Live-Log“ sehen, ob der Server zum Beispiel sehr viele 400er (Zugriff verboten) oder 500er (Serverprobleme) Status-Codes ausliefert.

Fazit

Wenn du diese drei Fehlerquellen geprüft hast, wirst du in den meisten Fällen jetzt schon wissen, warum die Seite nicht mehr in Googles Index vertreten ist.

Jetzt heißt es, in die Hände spucken und den oder die Fehler beheben.

Was mache ich nach der Beseitigung der Fehler?

Sobald die Gründe, die Google vom Crawlen/Indexieren der Seite abhalten, beseitigt sind, ist der nächste Schritt die Seite so schnell wie möglich erneut von Google crawlen und indexieren zu lassen.

Hier kannst du die Funktion „Indexierung beantragen“ in der Google Search Console nutzen, um bis zu 500 URLs erneut crawlen zu lassen und dann an den Index zu senden. Ihr könnt auch eine HTML-Datei mit allen (oder den wichtigsten) Unterseiten der Domain erstellen und diese mit der Einstellung „Diese URL und ihre direkten Links crawlen“ ausführen.

Solltest Du die Google Search Console nicht nutzen, so kannst Du Deine Website für die kostenlose Nutzung der Google Search Console (www.google.com/webmasters/tools/?hl=de) in wenigen Minuten freischalten und ebenfalls folgende Möglichkeit zur manuellen Indexierung von neuen Inhalten nutzen.

Eine weitere Möglichkeit besteht darin, eine XML-Sitemap zu erstellen und diese bei Google einzureichen.

Sobald Google die Seiten erneut gecrawlt und indexiert hat, muss die Suchmaschine prüfen, ob sich die Seiten geändert haben. Sind die Seiten jedoch weiterhin identisch zu der Version vor der Deindexierung, kann Google dies meist recht schnell erkennen und die URLs wieder für die alten Rankings anzeigen.