Manchmal kommt es vor, dass die Kennzahlen aus einer Google site:-Abfrage, der Google Search Console (GSC) und der SISTRIX Toolbox nicht übereinstimmen. Warum ist das so?

Die Daten einer Google site:-Abfrage und den der GSC lassen sich per se nicht miteinander vergleichen, da die Zahlen in der Search Console von Google gesondert berechnet werden. Daher kommen sie zu anderen Ergebnissen, die auch zu anderen Zeitpunkten veröffentlicht werden.

Vergleich der indexierten Seiten: Google site:-Abfrage und die SISTRIX-Daten

Ein Vergleich: Eine site:-Abfrage bei Google:

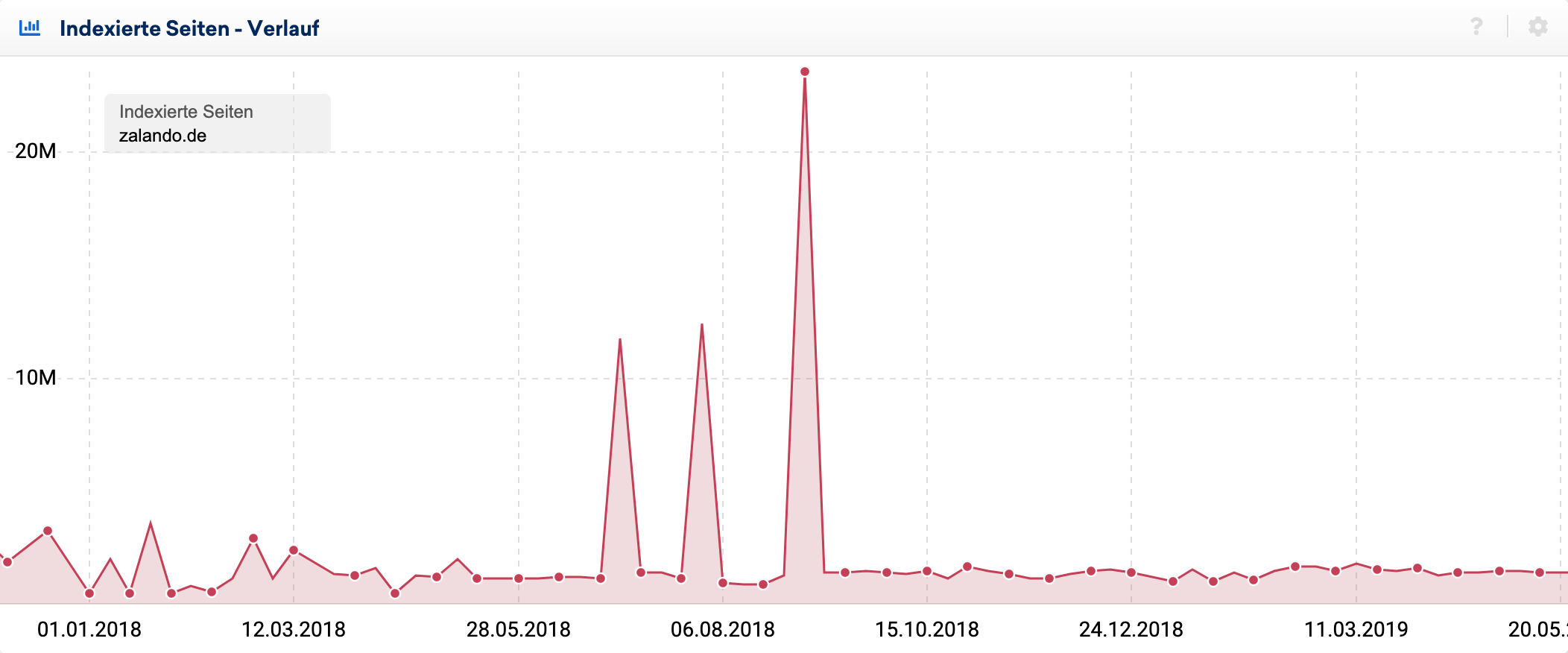

Und die indexierten Seiten der gleichen Domain in der SISTRIX Toolbox:

Die Anzahl der indexierten Seiten in der SISTRIX Toolbox ist ein Durchschnittswert

Die Anzahl indexierter Seiten ist laut Aussagen von Google bei über 1.000 Seiten eine grobe Schätzung – man beachte das Wort „Ungefähr“ vor den Ergebnissen. Um die größten Ausreißer zu eliminieren, erheben wir bei SISTRIX mehrmals wöchentlich Daten zu den indexierten Seiten und errechnen dann einen Durchschnittswert.

Wir führen dabei Abfragen mit dem Suchoperator site: bei Google durch. Unsere Zahlen kommen also von Google, wir berechnen nur noch zusätzlich einen Durchschnittswert. Wenn die Zahlen zwischenzeitlich bei uns gesunken (oder gestiegen) sind, dann sind das die Zahlen, die Google bei der site:-Abfrage so ausgeliefert hat.

Stark schwankende Werte sollten untersucht werden

Trotzdem sollte man sich bei stark schwankenden Werten mit der Ursache beschäftigen. In vielen Fällen sind Duplicate Content oder Inhalte, die Google als wenig wertvoll einstuft, die Ursache. Google indexiert die Seiten erst einmal (die Anzahl indexierter Seiten geht hoch) und filtert Duplikate und weniger wertvolle Seiten dann wieder aus (die Anzahl indexierter Seiten geht runter). Dies gilt ebenfalls für z.B. Druckversionen, Sessions IDs, Affiliate-Links u.a.

Beispiel anhand von red-simon.com

Um die Ursache näher zu beleuchten haben wir manuell eine site:-Abfrage bei Google in der Form site:red-simon.com durchgeführt und uns dann insbesondere die hinteren Treffer angeschaut.

Bei red-simon.com zeigte sich, dass sehr viele dynamische URLs in den Suchergebnissen zu finden waren, die viele Parameter enthalten. Darunter z. B.

red-simon.com/data/cmsv2.asp?mid=41&sid=1&pid=533

Diese Inhalte sind wahrscheinlich unter verschiedenen URLs erreichbar und somit Duplikate. Teilweise werden sie auch per 302-Redirect (temporär) weitergeleitet, was Google leicht verwirren kann. Bei Weiterleitungen sollte man immer 301-Redirects verwenden.

Es wäre sicherlich gut für die Website, wenn man die dynamischen URLs entfernt und durch statische URLs ersetzt. Weiterleitungen mit mod_rewrite wäre hier z.B. ein Lösungsansatz.

- Mehr zu Analysemöglichkeiten bei einer stark schwankender Anzahl von indexierten Seiten:

Warum schwankt die Anzahl der indexierten Seiten so stark?