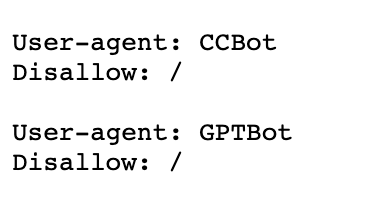

Die bislang recht liberalen Crawling-Vorgaben, welche die New York Times in der eigenen robots.txt macht, sind neuerdings um zwei Einträge erweitert: sowohl der CommonCrawl-Webindex (“CCBot”) als auch der OpenAI-Webcrawler (“GPTBot”) dürften auf die Inhalte der Zeitung nicht mehr zugreifen.

Gerüchten zufolge hat die NYT in den letzten Wochen versucht, ein Abkommen mit OpenAI über die Nutzung der Inhalte zu erzielen, ist aber gescheitert. Jetzt prüfe man angeblich sogar eine Klage gegen OpenAI. Nach der anfänglichen Euphorie zu generativer AI zeigt sich langsam, dass das offene Web auf der Verliererseite der AI-Entwicklung stehen könnte.

Die Motivation für das Anbieten öffentlich verfügbarer Inhalte im Internet war bislang klar: Aufmerksamkeit und Sichtbarkeit haben entweder direkt oder indirekt zu Erlösen geführt und den Aufwand damit auch wirtschaftlich für den Anbieter interessant gemacht.

In den letzten Jahren hat Google durch verschiedene vertikale Suchen oder auch die Featured Snippets versucht, dieses unausgesprochene Abkommen zu den eigenen Gunsten zu verschieben. Die neuen Möglichkeiten durch künstliche Intelligenz beschleunigen das jetzt: ein Besuch auf der Webseite ist nicht mehr nötig, die AI macht das für den Nutzer.

Der große Nachteil aus Sicht der Webseitenbetreiber: Die AI klickt auf keine Anzeigen, schließt keine Abos ab und hat leider auch sonst aus Vermarkersicht wenig Nutzen. Spätestens, wenn Google die Search Generative Experience ausrollt, wird der Konflikt offensichtlich und zum ernsthaften Problem vieler Internet-Geschäftsmodelle.